Trong bài viết này, TVD Media sẽ giải thích chi tiết về robots txt là gì, tầm quan trọng của nó trong SEO, cách tạo và tối ưu hóa tệp robots.txt để cải thiện hiệu suất trang web trên công cụ tìm kiếm.

robots txt là gì?

Tệp robots.txt là một tệp văn bản đơn giản nằm trong thư mục gốc của trang web, được sử dụng để hướng dẫn các công cụ tìm kiếm về những phần nào của trang web mà họ có thể hoặc không thể thu thập dữ liệu. Tệp này hoạt động như một bộ quy tắc mà các robot (bot) của công cụ tìm kiếm phải tuân thủ khi truy cập trang web.

Robots.txt được giới thiệu lần đầu vào năm 1994 bởi Martijn Koster, một trong những người tiên phong về công nghệ tìm kiếm web. Ban đầu, nó được tạo ra để giúp quản trị viên web kiểm soát việc thu thập dữ liệu trang web của các bot, nhằm bảo vệ tài nguyên máy chủ và ngăn chặn việc truy cập vào các trang nhạy cảm.

Vai trò của tệp robots.txt trong SEO

Kiểm soát việc thu thập dữ liệu

Tệp robots.txt cho phép bạn kiểm soát phần nào của trang web được các công cụ tìm kiếm thu thập dữ liệu. Điều này rất quan trọng để tối ưu hóa hiệu suất thu thập dữ liệu và tránh lãng phí tài nguyên vào các trang không quan trọng.

Ngăn chặn trùng lặp nội dung

Sử dụng tệp robots.txt giúp ngăn chặn các công cụ tìm kiếm truy cập vào các trang có nội dung trùng lặp hoặc không cần thiết, giúp tránh việc phân tán giá trị SEO và cải thiện xếp hạng trang web.

Bảo vệ dữ liệu nhạy cảm

Bạn có thể sử dụng tệp robots.txt để ngăn chặn truy cập vào các phần nhạy cảm của trang web như trang đăng nhập, trang quản trị hoặc bất kỳ thông tin nào mà bạn không muốn công khai.

Cách tạo tệp robots.txt

Các bước cơ bản

- Mở trình soạn thảo văn bản: Bạn có thể sử dụng bất kỳ trình soạn thảo văn bản nào như Notepad, TextEdit, hoặc một công cụ chỉnh sửa mã như Visual Studio Code.

- Viết các lệnh cần thiết: Sử dụng cú pháp đúng để chỉ định các quy tắc cho bot.

- Lưu tệp với tên robots.txt: Đảm bảo rằng tệp được lưu với đúng định dạng và tên tệp.

- Tải lên thư mục gốc của trang web: Sử dụng FTP hoặc các công cụ quản lý tệp để tải tệp lên thư mục gốc của trang web (thường là thư mục public_html).

Ví dụ:

User-agent: *

Disallow: /admin/

Disallow: /login/

Allow: /

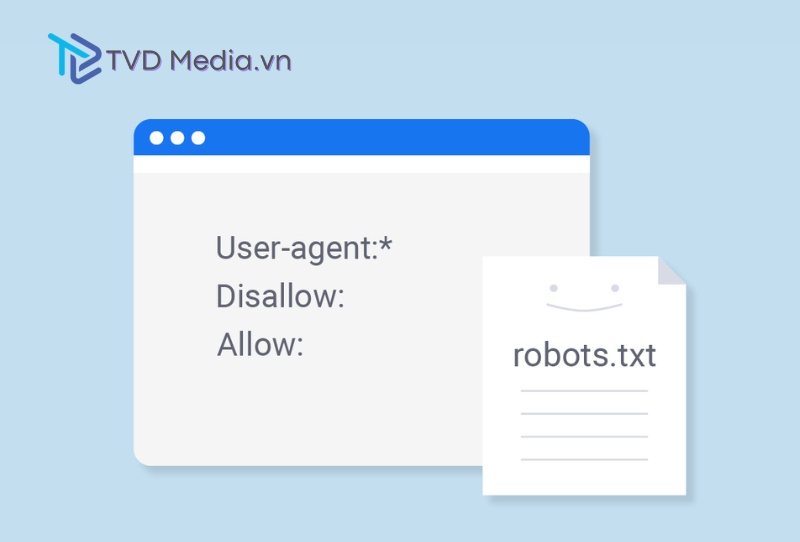

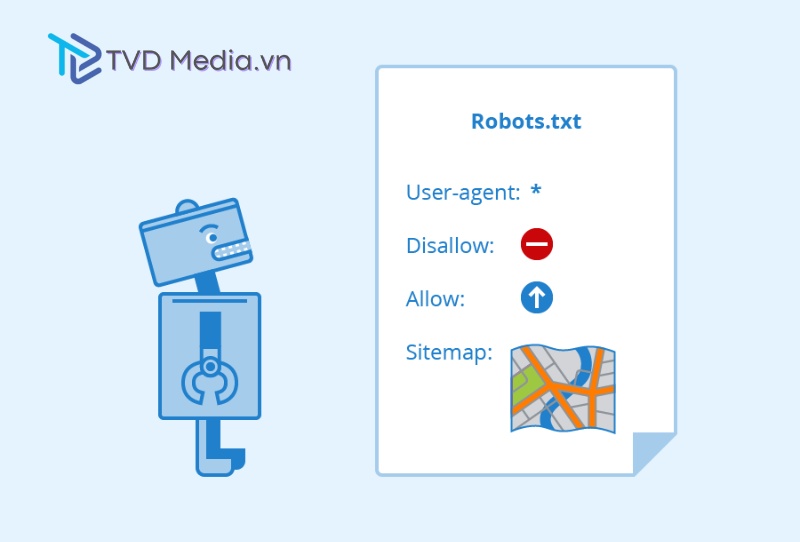

Cấu trúc của tệp robots.txt

User-agent: Phần “User-agent” xác định bot mà quy tắc sẽ áp dụng. Bạn có thể sử dụng dấu * để áp dụng cho tất cả các bot hoặc chỉ định tên cụ thể của bot.

Disallow: Lệnh “Disallow” ngăn chặn bot truy cập vào các URL được chỉ định. Nếu không có URL nào được chỉ định sau lệnh “Disallow”, điều đó có nghĩa là bot không bị chặn bất kỳ trang nào.

Allow: Lệnh “Allow” cho phép bot truy cập vào các URL cụ thể, ngay cả khi chúng nằm trong một thư mục bị chặn bởi lệnh “Disallow”.

Các lệnh phổ biến trong tệp robots.txt

Disallow

Lệnh “Disallow” được sử dụng để ngăn chặn truy cập vào một trang hoặc thư mục cụ thể.

Ví dụ:

User-agent: *

Disallow: /private/

Allow

Lệnh “Allow” thường được sử dụng trong trường hợp bạn muốn cho phép truy cập vào một trang cụ thể trong một thư mục bị chặn.

Ví dụ:

User-agent: *

Disallow: /private/

Allow: /private/public-page.html

Sitemap

Lệnh “Sitemap” cho phép bạn chỉ định vị trí của tệp sitemap.xml của trang web, giúp các công cụ tìm kiếm dễ dàng thu thập dữ liệu hơn.

VD: Sitemap: https://www.example.com/sitemap.xml

Cách kiểm tra và tối ưu hóa tệp robots.txt

Sử dụng công cụ kiểm tra robots.txt: Các công cụ như Google Search Console cung cấp chức năng kiểm tra tệp robots.txt, giúp bạn kiểm tra và xác minh các quy tắc trong tệp.

Kiểm tra thủ công: Bạn có thể kiểm tra tệp robots.txt bằng cách truy cập trực tiếp vào URL https://www.example.com/robots.txt để xem nội dung của tệp.

Tối ưu hóa tệp robots.txt

- Kiểm tra thường xuyên: Đảm bảo rằng tệp robots.txt luôn được cập nhật để phản ánh các thay đổi trên trang web.

- Tránh chặn các trang quan trọng: Đảm bảo rằng các trang quan trọng không bị vô tình chặn bởi các lệnh trong tệp robots.txt.

- Sử dụng lệnh chính xác: Đảm bảo sử dụng các lệnh “Disallow” và “Allow” đúng cách để tránh xung đột và nhầm lẫn.

Kết luận

Tệp robots.txt là một công cụ quan trọng trong việc kiểm soát việc thu thập dữ liệu của các công cụ tìm kiếm, giúp tối ưu hóa hiệu suất SEO của trang web. Việc hiểu rõ và sử dụng đúng cách tệp robots.txt sẽ giúp bạn cải thiện hiệu quả hoạt động của trang web trên các công cụ tìm kiếm, đồng thời bảo vệ được các phần thông tin nhạy cảm.

Hy vọng qua bài viết này, bạn đã hiểu rõ hơn về robots txt là gì và cách sử dụng nó để tối ưu hóa trang web của mình.

TVD Media

TVD Media